Mục lục:

- Tác giả Stanley Ellington ellington@answers-business.com.

- Public 2023-12-16 00:25.

- Sửa đổi lần cuối 2025-01-22 16:18.

Để phục vụ mô hình Tensorflow , chỉ cần xuất một SavedModel từ Tensorflow chương trình. SavedModel là một định dạng tuần tự hóa kín ngôn ngữ, có thể phục hồi, cho phép các hệ thống và công cụ cấp cao hơn sản xuất, tiêu thụ và chuyển đổi Mô hình TensorFlow.

Theo đó, làm cách nào để chạy mô hình TensorFlow?

Đây là các bước chúng tôi sẽ làm:

- Làm một mô hình ngu ngốc làm ví dụ, đào tạo và lưu trữ nó.

- Tìm nạp các biến bạn cần từ mô hình được lưu trữ của bạn.

- Xây dựng thông tin tensor từ chúng.

- Tạo chữ ký mô hình.

- Tạo và lưu trình tạo mô hình.

- Tải xuống hình ảnh Docker với phục vụ TensorFlow đã được biên dịch trên đó.

Ngoài ra, TensorFlow đang phục vụ những gì? TensorFlow phục vụ là một linh hoạt, hiệu suất cao phục vụ hệ thống cho các mô hình học máy, được thiết kế cho môi trường sản xuất. TensorFlow phục vụ cung cấp tích hợp ngoài hộp với TensorFlow nhưng có thể dễ dàng mở rộng sang phục vụ các loại mô hình và dữ liệu khác.

Về điều này, TensorFlow phục vụ hoạt động như thế nào?

TensorFlow phục vụ cho phép chúng tôi chọn phiên bản của mô hình hoặc "dịch vụ" mà chúng tôi muốn sử dụng khi chúng tôi đưa ra các yêu cầu suy luận. Mỗi phiên bản sẽ được xuất sang một thư mục con khác nhau theo đường dẫn đã cho.

Máy chủ mô hình là gì?

Máy chủ mô hình cho Apache MXNet (MMS) là một thành phần mã nguồn mở được thiết kế để đơn giản hóa nhiệm vụ triển khai học sâu người mẫu để suy luận ở quy mô lớn. Triển khai người mẫu để suy luận không phải là một nhiệm vụ tầm thường.

Đề xuất:

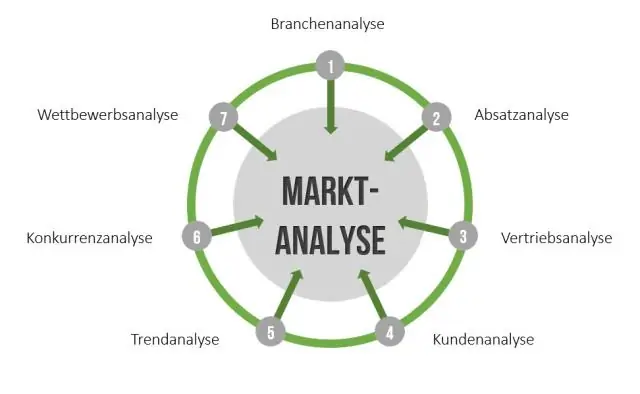

Bạn lập bản đồ quy trình bán hàng như thế nào?

Khi nói đến việc vạch ra quy trình bán hàng của bạn, có bảy bước cơ bản: Hiểu các giai đoạn quy trình tạo nên tổ chức bán hàng của bạn. Xác định cấu trúc để lập bản đồ bán hàng. Lập bản đồ Quy trình Trạng thái Hiện tại. Xem lại Trạng thái Hiện tại để biết Điểm mạnh và Cơ hội. Tạo bản đồ quy trình trạng thái trong tương lai

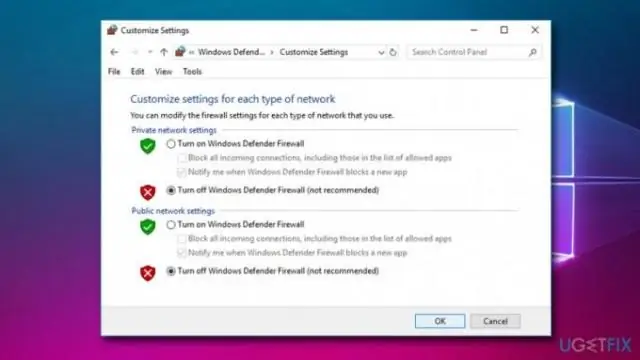

Bạn sử dụng cách tiếp cận có hệ thống để khắc phục sự cố như thế nào?

Phương pháp tiếp cận có hệ thống đối với kế hoạch giải quyết vấn đề. Trong giai đoạn Lập kế hoạch, nguyên nhân của vấn đề được xác định và một giải pháp được thiết kế. Làm. Trong giai đoạn Do, giải pháp được thực hiện. Đánh dấu. Trong giai đoạn Kiểm tra, kết quả được xem xét để xác định xem vấn đề đã được giải quyết hay chưa và định lượng lợi ích. hành động

Bạn cấu trúc một nghiên cứu điển hình kinh doanh như thế nào?

Cách viết một nghiên cứu điển hình kinh doanh: Hướng dẫn đầy đủ của bạn trong 5 bước Xác định cách tốt nhất có thể cho dữ liệu của bạn. Viết nghiên cứu điển hình của bạn (5 mẹo quan trọng) Kết thúc nghiên cứu điển hình với tất cả thông tin liên quan của bạn. Thuê một nhà thiết kế để hoàn thiện sản phẩm. Xuất bản nghiên cứu điển hình

Hình thức bán hàng trả góp như thế nào?

Bán hàng trả góp là giao dịch trong đó một người bán tài sản vốn cho người mua theo thời gian và ít nhất một khoản thanh toán được nhận trong một năm sau năm bán hàng. Cộng với người mua sẽ trả lãi lần thứ hai và thứ ba

Mô hình Ramsey khác với mô hình Solow như thế nào?

Mô hình Ramsey – Cass – Koopmans khác với mô hình Solow – Swan ở chỗ sự lựa chọn tiêu dùng rõ ràng là vi mô tại một thời điểm và do đó sinh ra tỷ lệ tiết kiệm. Kết quả là, không giống như trong mô hình Solow – Swan, tỷ lệ tiết kiệm có thể không cố định trong quá trình chuyển đổi sang trạng thái ổn định trong dài hạn